28 Ocak 2025 Salı

ollamaopen-webuideepseek

DeepSeek-R1 Modelini Ollama ve Open-WebUI ile Local Olarak Çalıştırmak

Son günlerde DeepSeek’in open-source olarak sunduğu başarılı modeller bir hayli konuşuluyor. Özellikle DeepSeek-R1, doğal dil işleme (NLP) alanında güçlü bir model olarak dikkat çekiyor. Ben de bunu fırsat bilip, kendi M4 Mac Mini (16GB) cihazımda hem Ollama hem de Open-WebUI ile çalıştırmaya karar verdim. Süreç oldukça basit ve eğlenceliydi, o yüzden burada sizinle de paylaşmak istedim!

Neden Open-WebUI?

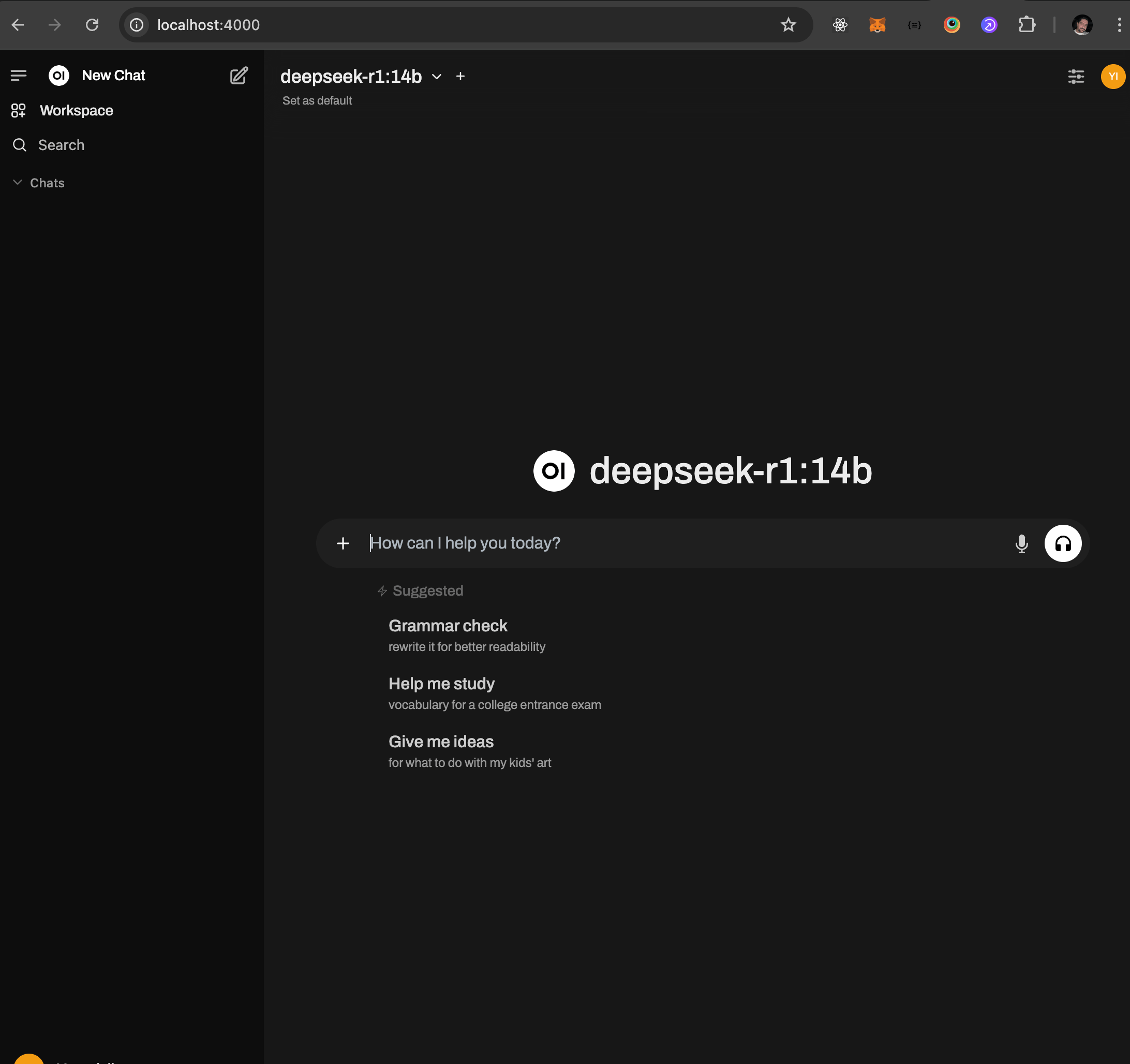

DeepSeek gibi local modelleri çalıştırmak istiyorsanız, bunu basit ve kullanıcı dostu bir arayüzle yapmak her zaman avantajlı. İşte tam bu noktada Open-WebUI devreye giriyor. Web tabanlı bu araç, yerel olarak çalışan modellerinizi bir ChatGPT benzeri bir arayüzde kullanmanıza olanak tanıyor.

Ayrıca, kurulum için Docker kullanılıyor ve tüm süreç sadece birkaç dakika sürüyor. Haydi, bu aracı nasıl kullanacağınızı adım adım anlatalım.

Open-WebUI’yi Docker ile Kurma

Open-WebUI’yi cihazınıza kurmak için ihtiyacınız olan tek şey Docker. Aşağıdaki komutu terminale yapıştırıp çalıştırmanız yeterli:

docker run -d -p 4000:8080 --add-host=host.docker.internal:host-gateway -v openweb:/app/backend/data --name openweb --restart always ghcr.io/open-webui/open-webui:main

Bu komut, Open-WebUI’yi çalıştırmak için gerekli tüm ayarları yapıyor ve sistemi başlatıyor. İşlem tamamlandığında, web tarayıcınızı açıp http://localhost:4000 adresine gidebilirsiniz.

Tarayıcıda Open-WebUI açıldığında, öncelikle kendinize bir admin hesabı oluşturmanız gerekiyor. Bunun için basit bir kayıt formu sizi karşılıyor. Kayıt işlemi tamamlandığında, arayüzde modellerinizi ekleyip kullanmaya başlayabilirsiniz.

Ollama ile DeepSeek-R1 Modelini İndirme

Şimdi sıra geldi modeli cihazımıza çekmeye. Ollama, yerel modelleri yönetmek ve çalıştırmak için mükemmel bir araç. İlk olarak Ollama’yı kurmamız gerekiyor.

Ollama’yı İndirin

Ollama’nın resmi sitesinden size uygun versiyonu indirip cihazınıza kurun. MacOS kullanıcıları için süreç oldukça hızlı ve kolay.

DeepSeek-R1 Modelini Pull Etme

Ollama kurulduktan sonra, terminalde aşağıdaki komutu çalıştırarak DeepSeek-R1 modelini cihazınıza indirin:

ollama pull deepseek-r1:8b

Not: Cihazınıza uygun model boyutunu seçtiğinizden emin olun. Örneğin, benim M4 Mac Mini (16GB) cihazım, 8B modelini sorunsuz çalıştırabiliyor. Daha düşük RAM’e sahipseniz daha küçük bir model seçebilirsiniz.

Bu komut ile model cihazınıza indiriliyor ve Open-WebUI’ye entegre etmek için hazır hale geliyor.

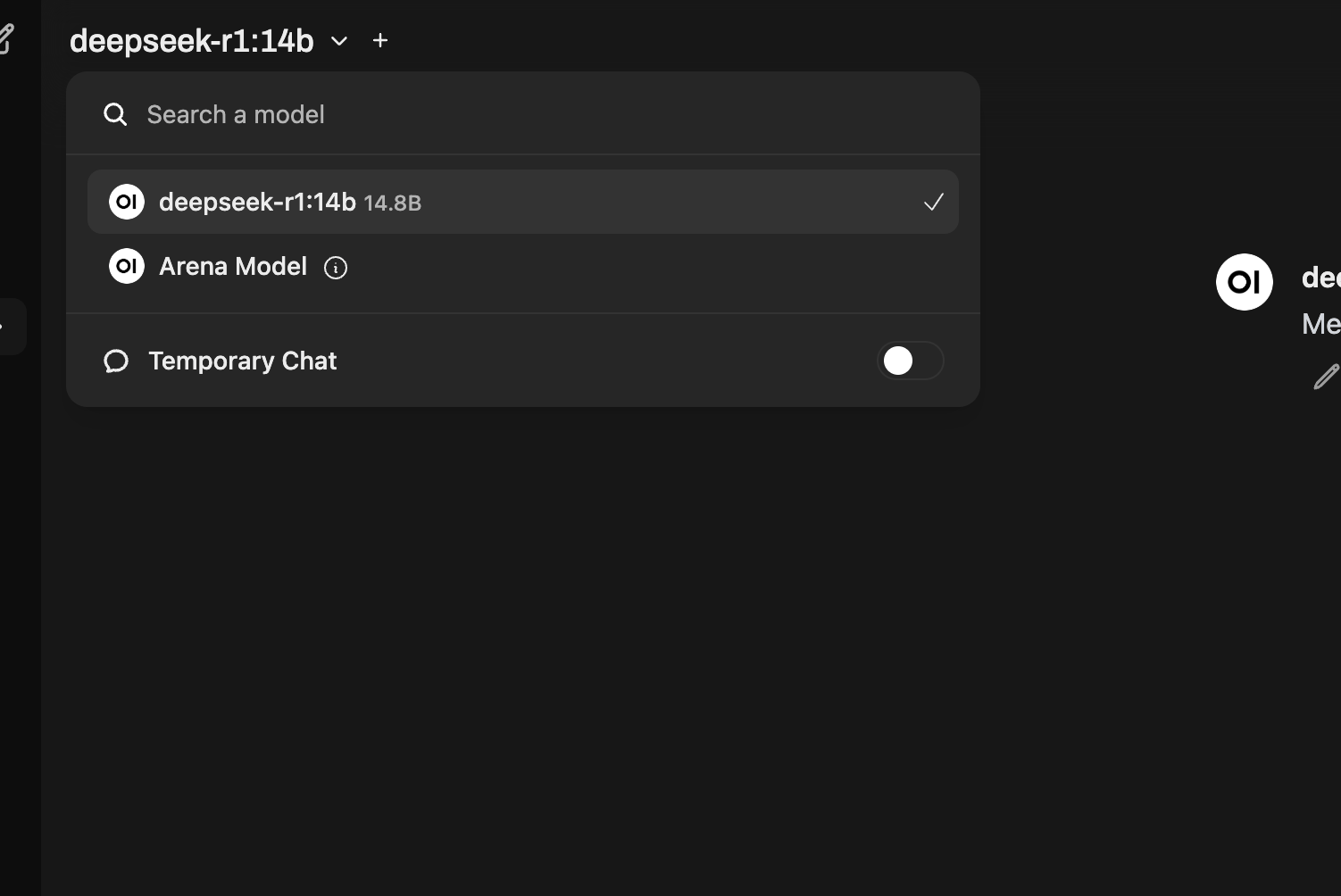

Open-WebUI’de Modeli Kullanma

Modelinizi Ollama ile indirdikten sonra, Open-WebUI arayüzüne geri dönün. Arayüz üzerinden modeli seçin ve bir sohbet başlatın. İşte bu kadar! Artık kendi local ChatGPT’nizle konuşmaya hazırsınız.